NotebookLM 音声解説(YouTube)

解説動画を見る『ドグラ・マグラ』音声(YouTube)

【完成動画(字幕あり)】CeVIO AIで朗読した完成版をYouTubeに公開しました。字幕ON推奨です。

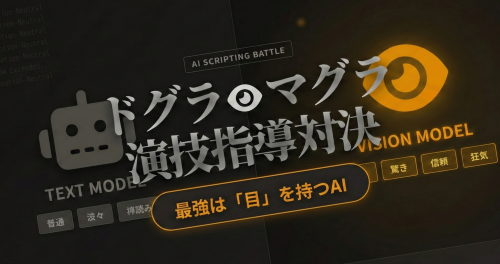

AIに「狂気」を演じさせる。

最強の脚本家は誰だ?

日本三大奇書『ドグラ・マグラ』のボイスドラマ化に向けた、LLM 4モデルの比較検証レポート。

勝者は「一番賢いAI」ではなく、「目を持つAI」でした。

難攻不落の課題

なぜ『ドグラ・マグラ』の台本化は難しいのか? AIを狂わせる3つの要因。

話者の喪失

若林博士の長広舌とナレーションの境界が極めて曖昧。多くのAIが「今誰が喋っているのか」を見失い、配役を誤ります。

狂気的な感情

単なる「朗読」では作品の味が出ません。「恐れ」「驚き」「信頼」など、文脈の裏にある狂気的な感情指定が不可欠です。

解釈の多義性

文学的すぎるテキストは、AIの「賢さ」を暴走させます。勝手な考察を始めてしまうリスクも。

4モデル頂上決戦

各モデルの特性と出力結果を比較分析(※数値は同一条件・同一分割での相対比較)

Qwen3-VL-30B

憑依型の舞台役者

視覚認識機能を持つことで、テキストから「情景」や「身振り」を想像できる唯一のモデル。配役の一貫性が完璧で、文脈の裏にある感情(恐怖、信頼)を的確に捉える。

感情表現の豊かさ

※“普通/恐れ/驚き/信頼/その他”の割合(出現タグの相対比)

配役タグの混乱度

非常に整理されており、実用的です。

Speaker,Emotion,Text ナレーター,普通(淡々),ドグラ・マグラ ナレーター,驚き,何故躍る ナレーター,恐れ,おそろしいのか ナレーター,普通(淡々),ブウウ――――――ンンン ナレーター,普通(淡々),私がウスウスと眼を覚ました時... 若林博士,信頼,...正木先生の御研究の内容を... 若林博士,普通(淡々),...すなわち、その一番初めに... 主人公,恐れ,な、なんだここは...!

強み (Pros)

- 博士の長台詞を維持できる

- 「信頼」「恐れ」等の感情が正確

- 修正の手間がほぼゼロ

弱点 (Cons)

- 30Bなので環境によっては重い

- ただし「修正コスト込み」では最速になりがち

なぜ「目」が演技を変えるのか?

テキスト生成タスクにおいて、視覚モデル (VL) が優位に立った理由は「想像力」と「身体性」にあります。

1. Visual Imagery(映像的想起)

テキストモデルは「暗い部屋」を単語の羅列として処理しがちですが、VLモデルは学習経験から“映像の雰囲気”を強く想起しやすい。 その差が「ここは怖い」を迷わず出せるかに効きます。

2. Embodiment(身体性の理解)

長台詞を“データ”ではなく、「人物がその場で演説している動作」として捉えやすい。 これが途中でナレーションに落ちるミスを減らします。

モデルの脳内イメージ比較

PROCESS: [Token Pattern Only]

OUTPUT: Emotion=”Neutral”

PROCESS: [Mood/Scene Simulation]

OUTPUT: Emotion=”Fear”

推奨設定シミュレーター

コンテキストウィンドウ(記憶領域)の黄金比を学ぶ

コメント